cyxCoder

明天你会感谢今天奋力拼搏的你。

ヾ(o◕∀◕)ノヾ

AI大模型系列:(一)大模型基础介绍

努力成为懂AI、懂编程、懂业务的全栈AI工程师。

一、大模型介绍

1.1、概念

AGI(Artificial General Intelligence):通用人工智能。

识别是否为AI的观点:基于机器学习、神经网络的是 AI,基于规则、搜索的不是 AI。

对待AI,要用「用人思维」:

- 机器思维:研发了什么功能,就有什么功能。

- 用人思维:给 ta 一个任务,总会有些反馈,或好或坏,惊喜或惊吓。

大模型:全称「大语言模型」,英文「Large Language Model」,缩写「LLM」。

市面上好用的大模型和对话产品介绍

|

国家 |

公司 |

对话产品 |

旗舰大模型 |

网址 |

|

美国 |

OpenAI |

ChatGPT |

GPT |

https://chatgpt.com/ |

|

美国 |

Microsoft |

Copilot |

GPT 和未知 |

https://copilot.microsoft.com/ |

|

美国 |

|

Gemini |

Gemini |

https://gemini.google.com/ |

|

美国 |

Anthropic |

Claude |

Claude |

https://claude.ai/ ,公认不输甚至超过 GPT 的 |

|

中国 |

百度 |

文心一言 |

文心 |

https://yiyan.baidu.com/ |

|

中国 |

阿里云 |

通义千问 |

通义千问 |

https://tongyi.aliyun.com/qianwen |

|

中国 |

智谱 AI |

智谱清言 |

GLM |

https://chatglm.cn/ |

|

中国 |

月之暗面 |

Kimi Chat |

Moonshot |

https://kimi.moonshot.cn/ |

|

中国 |

MiniMax |

星野 |

abab |

https://www.xingyeai.com/ |

|

中国 |

深度探索 |

deepseek |

DeepSeek |

https://chat.deepseek.com/ |

1.2、大模型原理简单介绍

训练和推理是大模型工作的两个核心过程,用人类比,训练就是学,推理就是用。

训练:

- 大模型阅读了人类说过的所有的话。这就是「机器学习」

- 训练过程会把不同 token 同时出现的概率存入「神经网络」文件。保存的数据就是「参数」,也叫「权重」。

推理:

- 我们给推理程序若干 token,程序会加载大模型权重,算出概率最高的下一个 token 是什么。

- 用生成的 token,再加上上文,就能继续生成下一个 token。以此类推,生成更多文字。

Token 是什么?

- 可能是一个英文单词,也可能是半个,三分之一个

- 可能是一个中文词,或者一个汉字,也可能是半个汉字,甚至三分之一个汉字

- 大模型在开训前,需要先训练一个 tokenizer 模型。它能把所有的文本,切成 token

这套生成机制的内核叫「Transformer 架构」。其目前是人工智能领域最广泛流行的架构,但transformer 已经不是最先进的了。当前的AI大模型架构有如下:

|

架构 |

设计者 |

特点 |

链接 |

|

Transformer |

|

最流行,几乎所有大模型都用它 |

|

|

RWKV |

PENG Bo |

可并行训练,推理性能极佳,适合在端侧使用 |

|

|

Mamba |

CMU & Princeton |

性能更佳,尤其适合长文本生成 |

|

|

Test-Time Training (TTT) |

Stanford, UC San Diego, UC Berkeley & Meta AI |

速度更快,长上下文更佳 |

目前只有 transformer 被证明了符合 scaling-law。

1.3、大模型能做啥

- 舆情分析:从公司产品的评论中,分析哪些功能/元素是用户讨论最多的,评价是正向还是负向

- 坐席质检:检查客服/销售人员与用户的对话记录,判断是否有争吵、辱骂、不当言论,话术是否符合标准

- 知识库:让大模型基于私有知识回答问题

- 零代码开发/运维:自动规划任务,生成指令,自动执行

- AI 编程:用 AI 编写代码,提升开发效率

二、大模型应用架构

大模型技术分两个部分:

训练基础大模型:全世界只需要 1000 人做这个

建造大模型应用:所有技术人,甚至所有人,都需要掌握

大模型应用技术特点:门槛低,天花板高。

2.1、产品架构

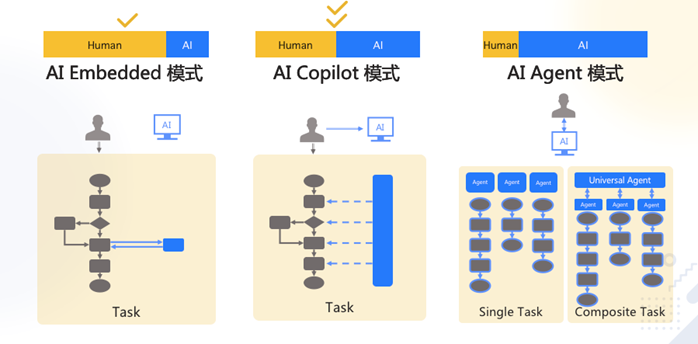

Agent 还太超前,Copilot是当前主流。

实现 Copilot 的主流架构是多 Agent 工作流:

- 模仿人做事,将业务拆成工作流(workflow、SOP、pipeline)。

- 每个 Agent 负责一个工作流节点。

2.2、技术架构

2.2.1、纯 Prompt(提示)

Prompt是操作大模型的唯一接口。

就像和一个人对话,你说一句,ta 回一句,你再说一句,ta 再回一句……

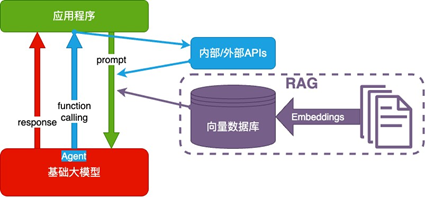

2.2.2、Agent + Function Calling

Agent:AI 主动提要求

Function Calling:AI 要求执行某个函数

场景举例:你问 ta「我明天去杭州出差,要带伞吗?」,ta 让你先看天气预报,你看了告诉 ta,ta 再告诉你要不要带伞。

2.2.3、RAG(Retrieval-Augmented Generation)

Embeddings:把文字转换为更易于相似度计算的编码。这种编码叫向量

向量数据库:把向量存起来,方便查找

向量搜索:根据输入向量,找到最相似的向量

场景举例:考试时,看到一道题,到书上找相关内容,再结合题目组成答案。然后,就都忘了

2.2.4、Fine-tuning(精调/微调)

努力学习考试内容,长期记住,活学活用。

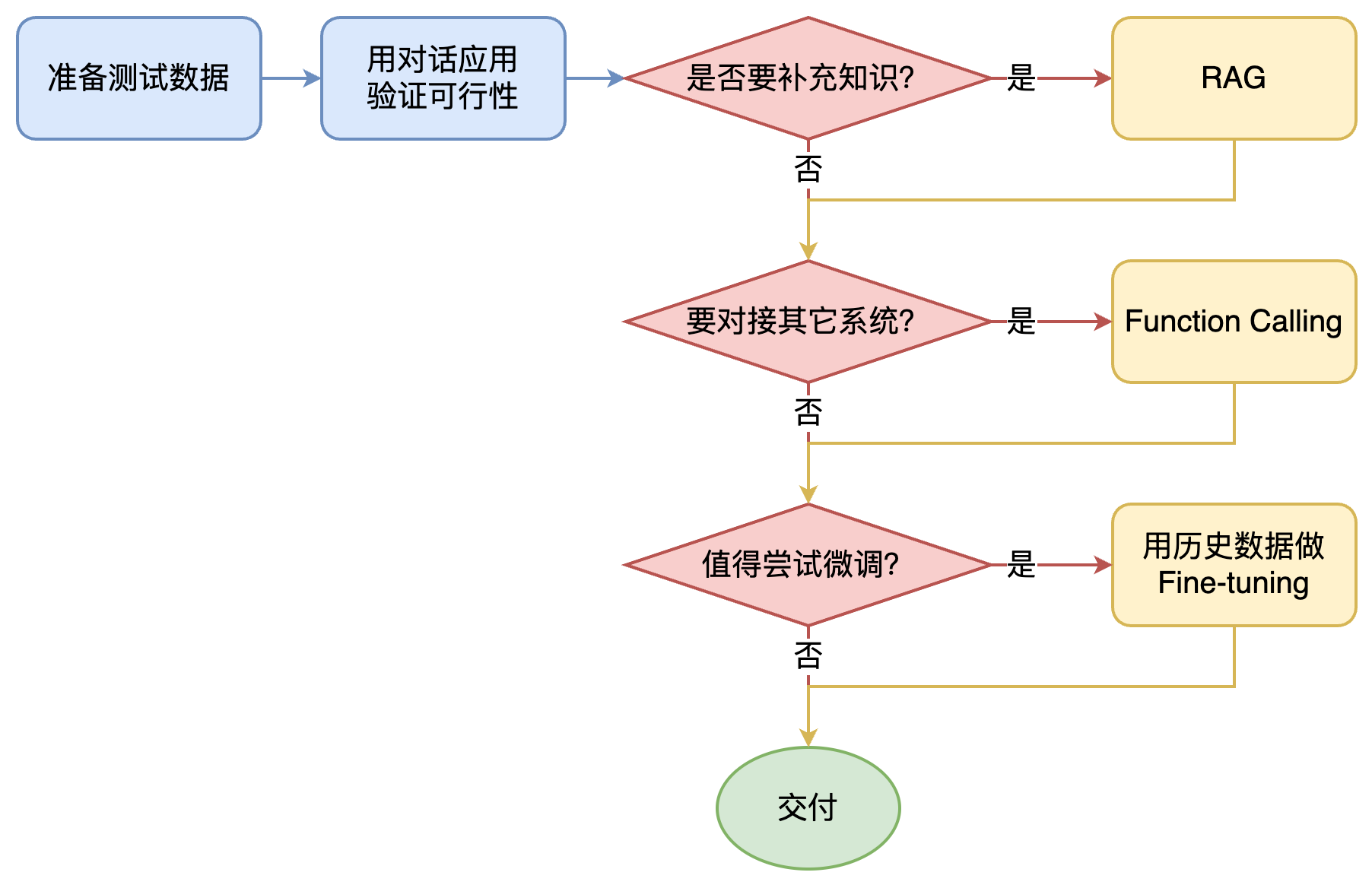

2.3、如何选择技术路线

面对一个需求,如何选择技术方案?下面是个不严谨但常用思路。

其中最容易被忽略的,是准备测试数据

值得尝试 Fine-tuning 的情况:

- 提高大模型的稳定性

- 用户量大,降低推理成本的意义很大

- 提高大模型的生成速度

- 需要私有部署

基础模型选型:

合规和安全是首要考量因素,如下列出哪些场景适合哪种大模型:

然后用测试数据,在可以选择的模型里,做测试,找出最优。

AI落地场景的思路:

- 从最熟悉的领域入手

- 让 AI 学最厉害员工的能力,再让 ta 辅助其他员工,实现降本增效

- 尽量找能用语言描述的任务

- 别求大而全。将任务拆解,先解决小任务、小场景

三、附录

内容引自孙志岗老师的AI 大模型系列课程:https://agiclass.ai/

全部评论